Apple ogłosił serię nowych inicjatyw dotyczących bezpieczeństwa dzieci, które pojawią się wraz z najnowszymi aktualizacjami iOS 15, iPadOS 15 i macOS Monterey i mają na celu zapewnienie dzieciom bezpieczeństwa w Internecie.

Firma poinformowała, że funkcje będą w momencie premiery tylko w USA i z czasem zostaną rozszerzone na inne regiony.

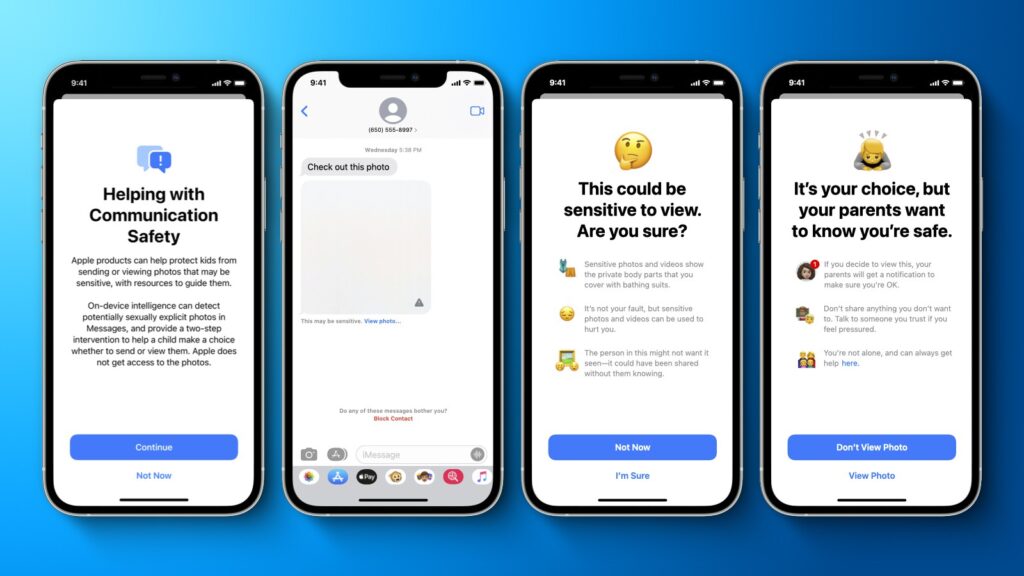

Bezpieczeństwo komunikacji

Po pierwsze, aplikacja Wiadomości na iPhonie, iPadzie i Macu otrzyma nową funkcję bezpieczeństwa komunikacji, aby ostrzegać dzieci i ich rodziców podczas odbierania lub wysyłania zdjęć o charakterze erotycznym. Apple powiedział, że aplikacja Wiadomości będzie wykorzystywać uczenie maszynowe na urządzeniu do analizowania załączników graficznych, a jeśli zdjęcie zostanie uznane za erotyczne, zdjęcie zostanie automatycznie zamazane, a dziecko zostanie ostrzeżone.

Gdy dziecko spróbuje wyświetlić zdjęcie oznaczone jako erotyczne w aplikacji Wiadomości, zostanie ostrzeżone, że zdjęcie może zawierać prywatne części ciała i może być szkodliwe. W zależności od wieku dziecka, będzie również dostępna opcja dla rodziców, aby mogli otrzymać powiadomienie, jeśli ich dziecko przejdzie do oglądania wrażliwego zdjęcia lub jeśli zdecyduje się wysłać zdjęcie o charakterze erotycznym do innego kontaktu po otrzymaniu ostrzeżenia.

Apple powiedział, że nowa funkcja bezpieczeństwa komunikacji pojawi się w aktualizacjach iOS 15, iPadOS 15 i macOS Monterey jeszcze w tym roku dla kont skonfigurowanych jako rodzinne w iCloud. Apple zapewnił, że konwersacje iMessage pozostaną chronione za pomocą pełnego szyfrowania, dzięki czemu prywatna komunikacja będzie nieczytelna dla Apple.

Skanowanie zdjęć iCloud w poszukiwaniu materiałów związanych z wykorzystywaniem seksualnym dzieci (CSAM)

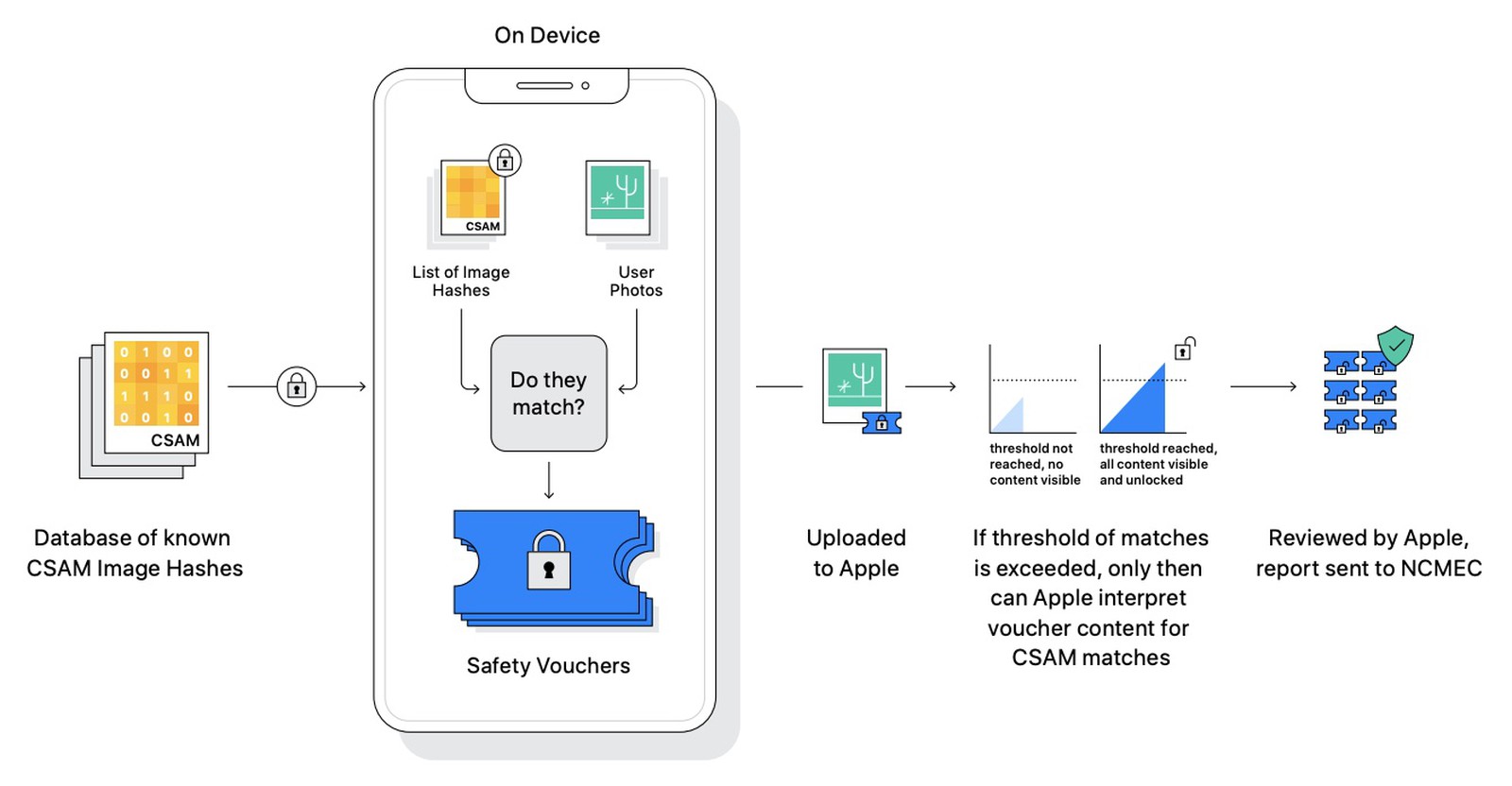

Po drugie, począwszy od tego roku i iOS 15 i iPadOS 15, Apple będzie w stanie wykrywać zdjęcia materiałów związanych z wykorzystywaniem seksualnym dzieci (CSAM) przechowywane w Zdjęciach iCloud, umożliwiając Apple zgłaszanie tych przypadków do National Center for Missing and Exploited Children (NCMEC) , organizacji non-profit, która współpracuje z amerykańskimi organami ścigania.

Apple powiedział, że jego metoda wykrywania znanych CSAM została zaprojektowana z myślą o prywatności użytkownika. Zamiast skanować obrazy w chmurze, Apple powiedział, że system wykona dopasowanie na urządzeniu do bazy danych znanych skrótów obrazów CSAM dostarczonych przez NCMEC i inne organizacje zajmujące się bezpieczeństwem dzieci. Apple powiedział, że jeszcze bardziej przekształci tę bazę danych w nieczytelny zestaw skrótów, który jest bezpiecznie przechowywany na urządzeniach użytkowników.

Według Apple technologia haszowania, zwana NeuralHash, analizuje obraz i konwertuje go na unikalny numer charakterystyczny dla tego obrazu.

„Głównym celem skrótu jest zapewnienie, że identyczne i wizualnie podobne obrazy dają ten sam skrót, podczas gdy obrazy różniące się od siebie dają różne skróty” — powiedział Apple w nowym dokumencie „Rozszerzona ochrona dla dzieci”. „Na przykład obraz, który został lekko przycięte, przeskalowane lub przekonwertowane z kolorowego na czarno-białe, jest traktowane identycznie jak oryginał i ma ten sam skrót”.

Apple powiedział, że zanim obraz zostanie zapisany w Zdjęciach iCloud, przeprowadzany jest proces dopasowywania na urządzeniu dla tego obrazu z nieczytelnym zestawem znanych skrótów CSAM. W przypadku dopasowania urządzenie tworzy kryptograficzny kupon bezpieczeństwa. Ten kupon jest przesyłany do usługi Zdjęcia iCloud wraz z obrazem, a po przekroczeniu nieujawnionego progu dopasowań firma Apple może zinterpretować zawartość kuponów dotyczących dopasowań CSAM. Apple następnie ręcznie sprawdza każdy raport, aby potwierdzić, że istnieje dopasowanie, wyłącza konto iCloud użytkownika i wysyła raport do NCMEC. Apple nie udostępnia swojego dokładnego progu, ale zapewnia „niezwykle wysoki poziom dokładności”, aby konta nie były nieprawidłowo oflagowane.

Apple powiedział, że jego metoda wykrywania znanych CSAM zapewnia „znaczące korzyści w zakresie prywatności” w porównaniu z istniejącymi technikami.

Technologia leżąca u podstaw systemu Apple jest dość złożona i firma opublikowała podsumowanie techniczne zawierające więcej szczegółów.

„Rozszerzona ochrona Apple dla dzieci zmienia zasady gry. Przy tak wielu osobach korzystających z produktów Apple te nowe środki bezpieczeństwa mogą uratować życie dzieciom, które są kuszone w Internecie i których przerażające obrazy krążą w materiałach dotyczących wykorzystywania seksualnego dzieci” – powiedział John Clark. , prezes i dyrektor generalny Narodowego Centrum Dzieci Zaginionych i Wykorzystywanych. „W National Center for Missing & Exploited Children wiemy, że tę zbrodnię można zwalczać tylko wtedy, gdy jesteśmy niezłomni w naszym zaangażowaniu w ochronę dzieci. Możemy to zrobić tylko dlatego, że partnerzy technologiczni, tacy jak Apple, podejmują działania i ujawniają swoje zaangażowanie. Rzeczywistość jest taka, że prywatność i ochrona dzieci mogą współistnieć. Pochwalamy Apple i czekamy na współpracę, aby uczynić ten świat bezpieczniejszym miejscem dla dzieci”.

Rozszerzone wskazówki CSAM w Siri i wyszukiwarce

Po trzecie, Apple powiedział, że rozszerzy wytyczne dotyczące Siri i Spotlight Search na różnych urządzeniach, zapewniając dodatkowe zasoby, aby pomóc dzieciom i rodzicom zachować bezpieczeństwo w Internecie i uzyskać pomoc w niebezpiecznych sytuacjach. Na przykład użytkownicy, którzy zapytają Siri, w jaki sposób mogą zgłosić CSAM lub wykorzystywanie dzieci, zostaną skierowani do zasobów dotyczących tego, gdzie i jak złożyć zgłoszenie.

Według Apple aktualizacje Siri i Search pojawią się jeszcze w tym roku w aktualizacji iOS 15, iPadOS 15, watchOS 8 i macOS Monterey.